[TOC]

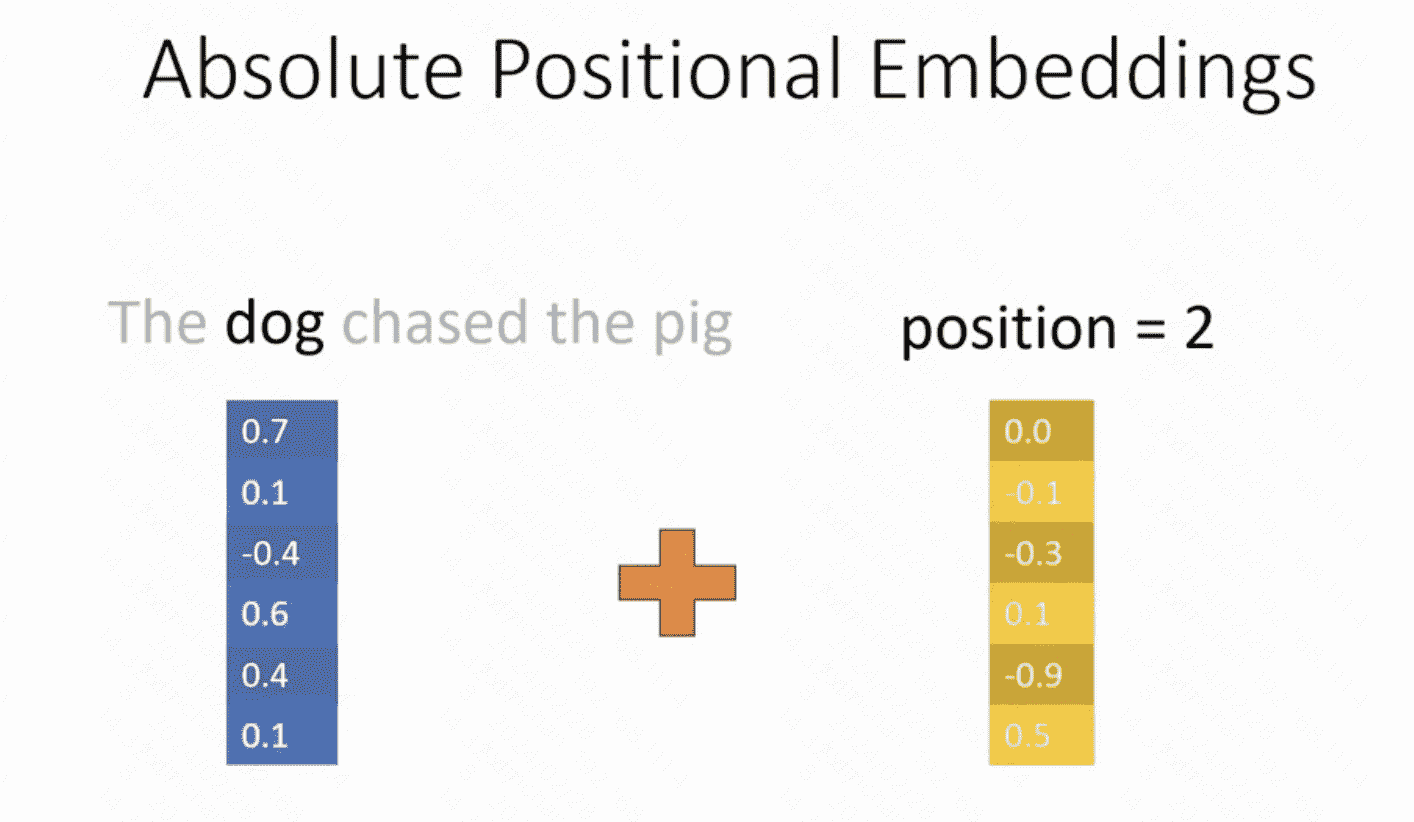

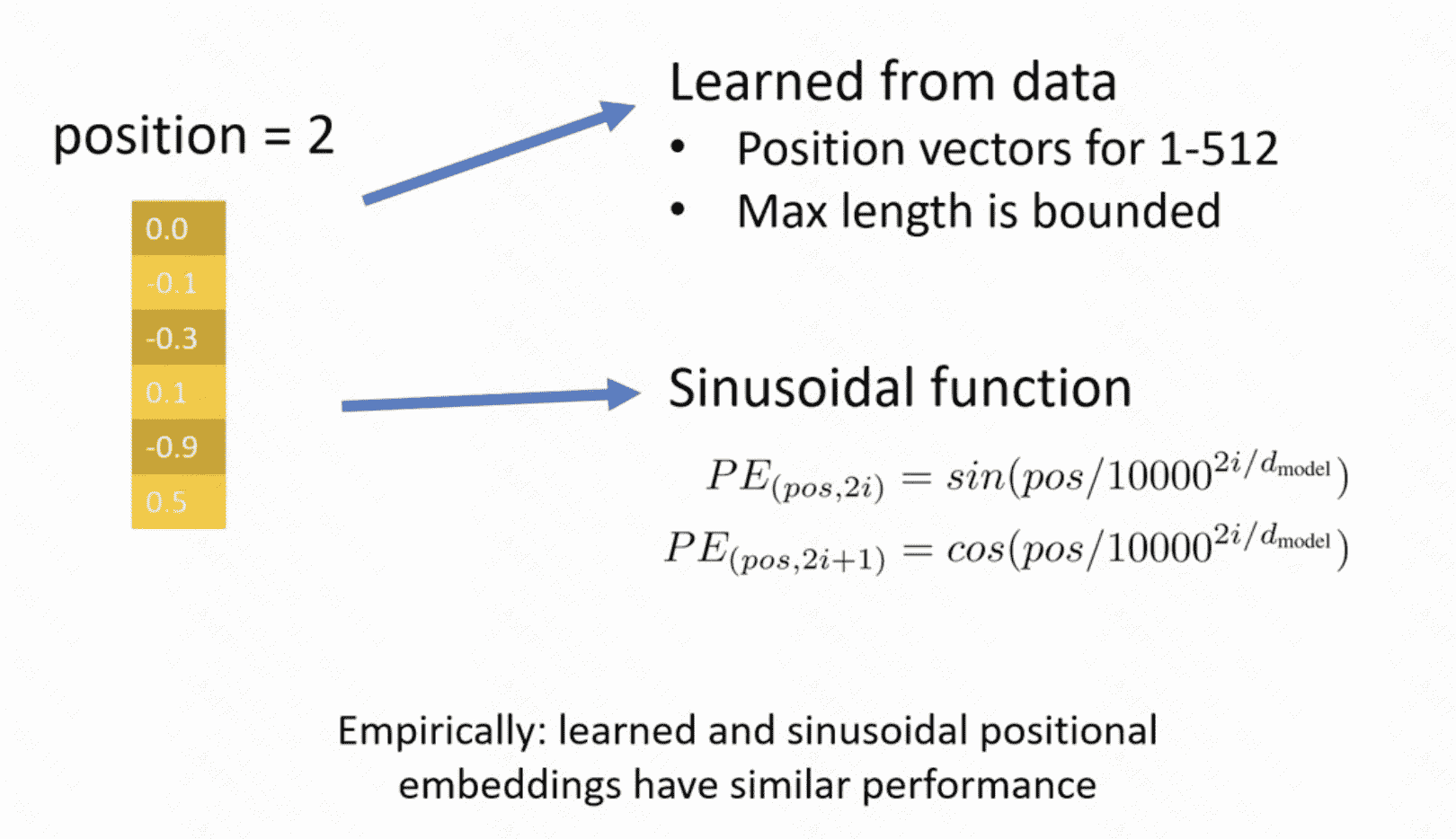

Absolute Positional Embedding

对每一个position产生一个embedding

有两种产生方式:

- Advantages:

- 会受到训练时候的max_length限制

- 不存在位置直接的关联,比如:我们希望P1和P2的相似性大于P1和P500的相似性

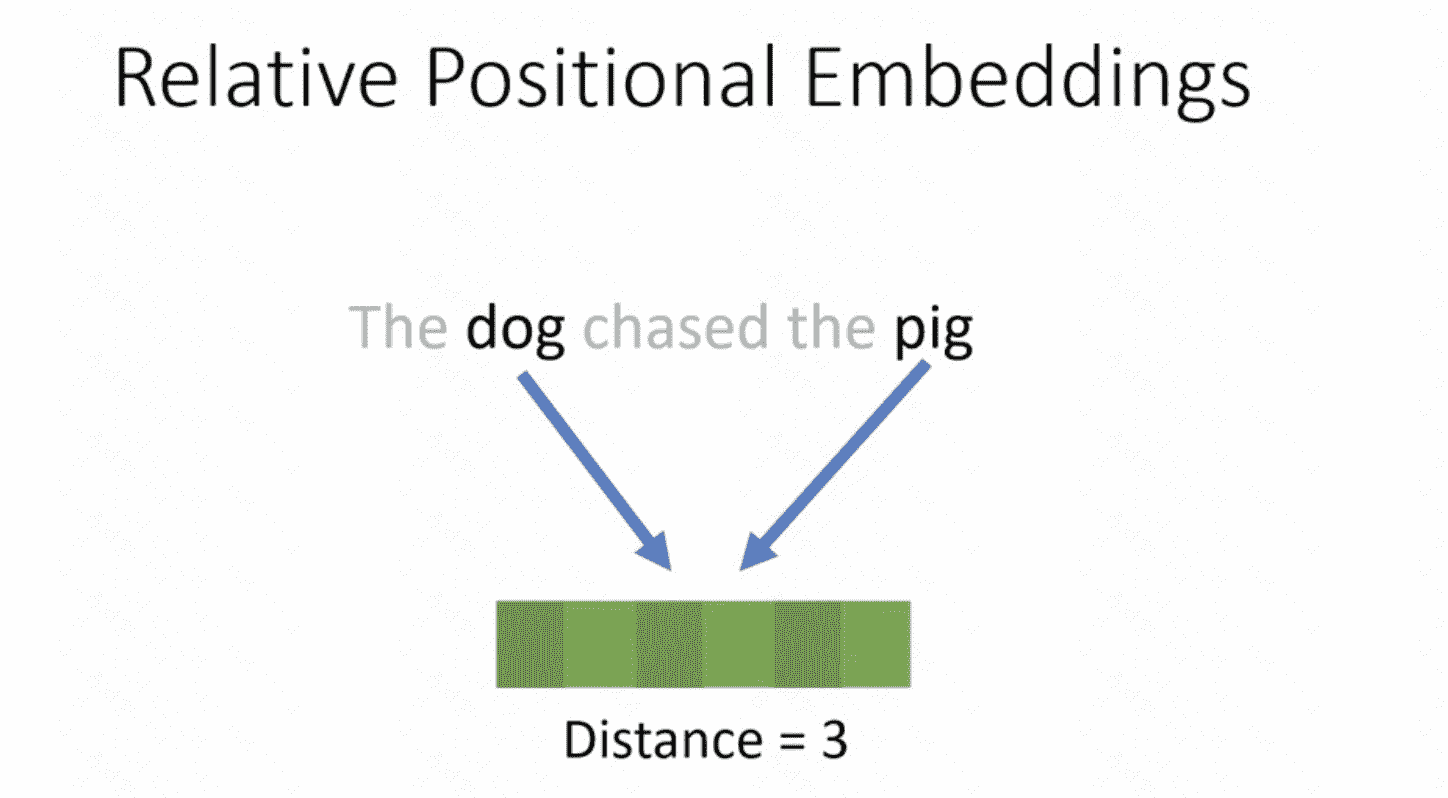

Relative Positional Embedding

转而学习两个位置差距的embedding

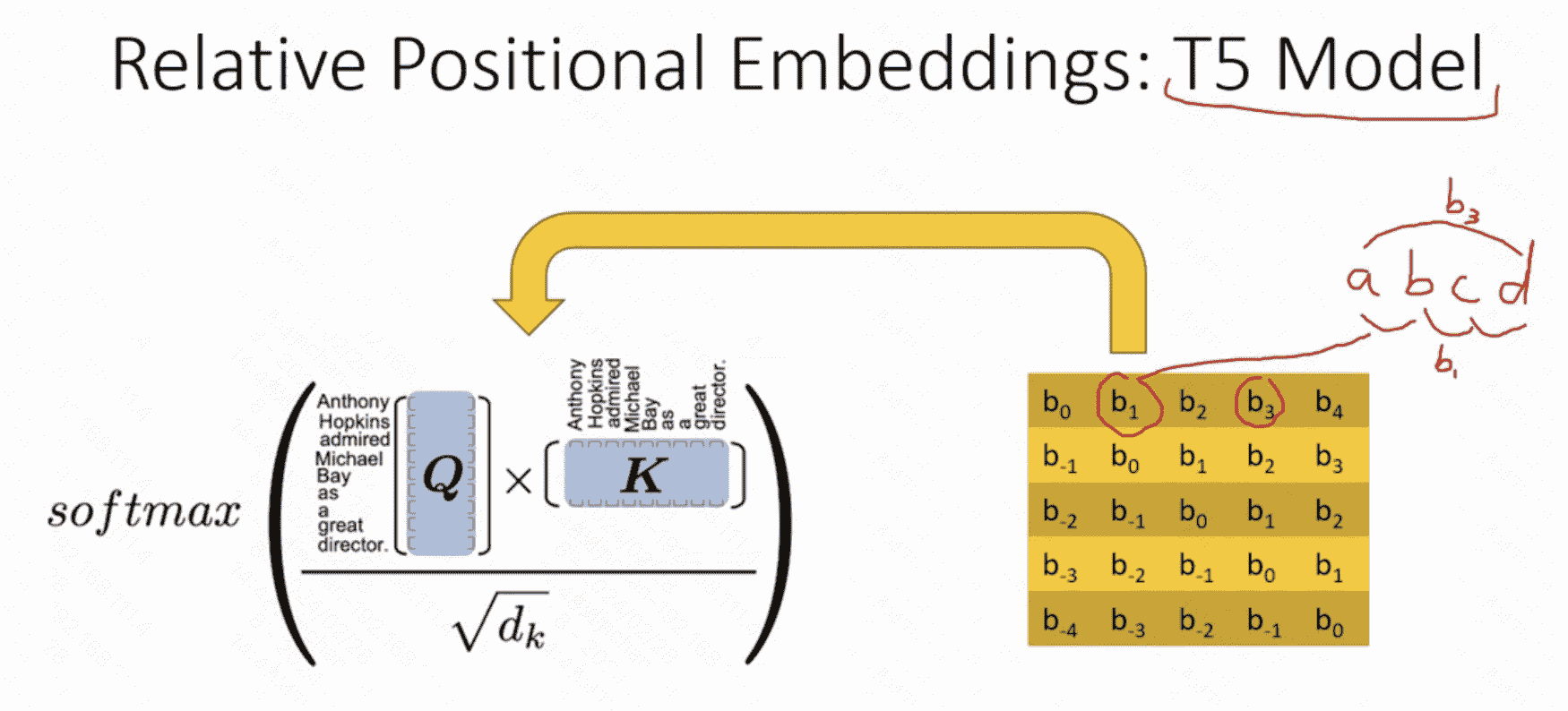

T5的相对位置编码

- 优点相对绝对位置编码而言:可以拓展到无限长的句子上去

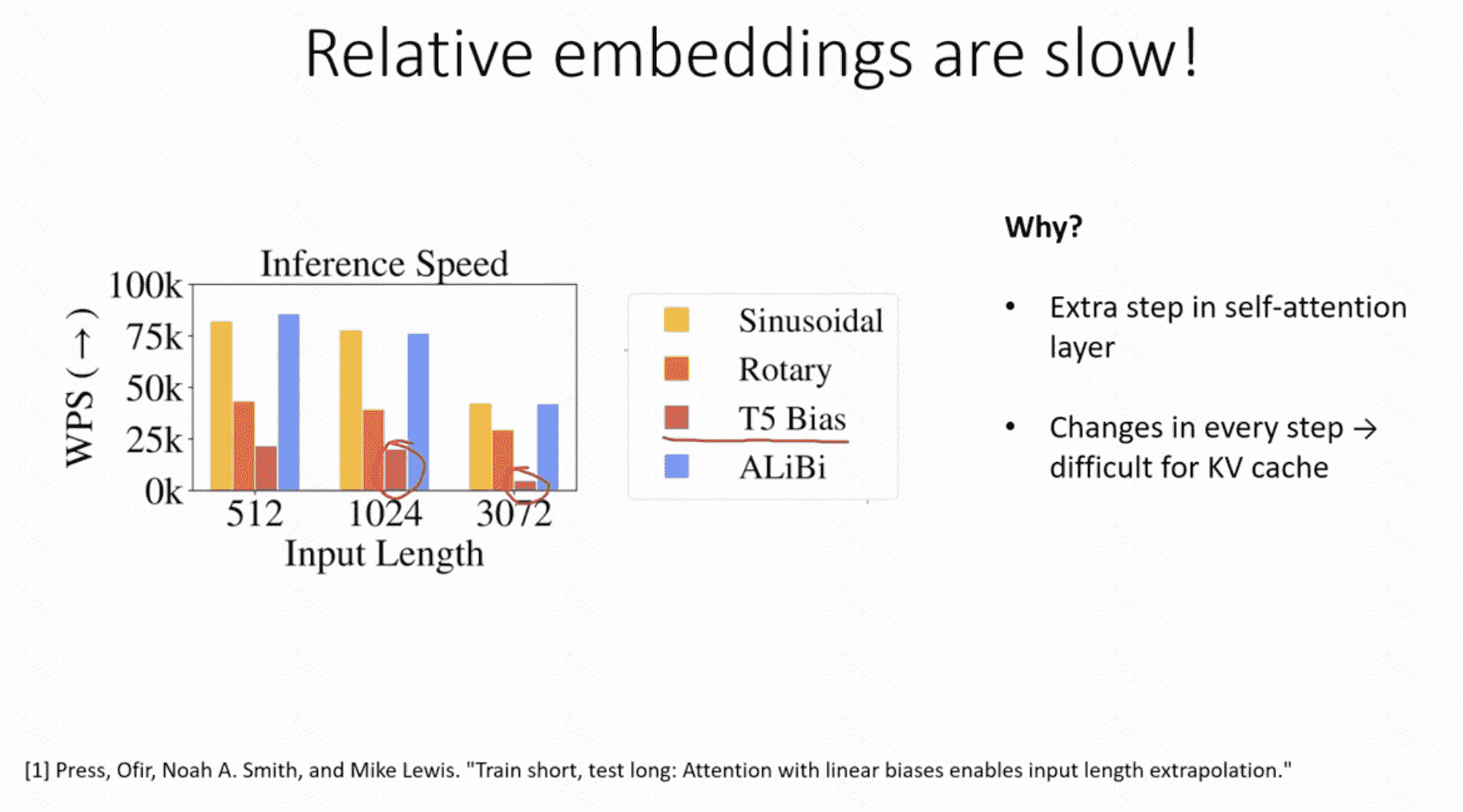

- 缺点:慢并且不能应用KV cache策略

RoPE

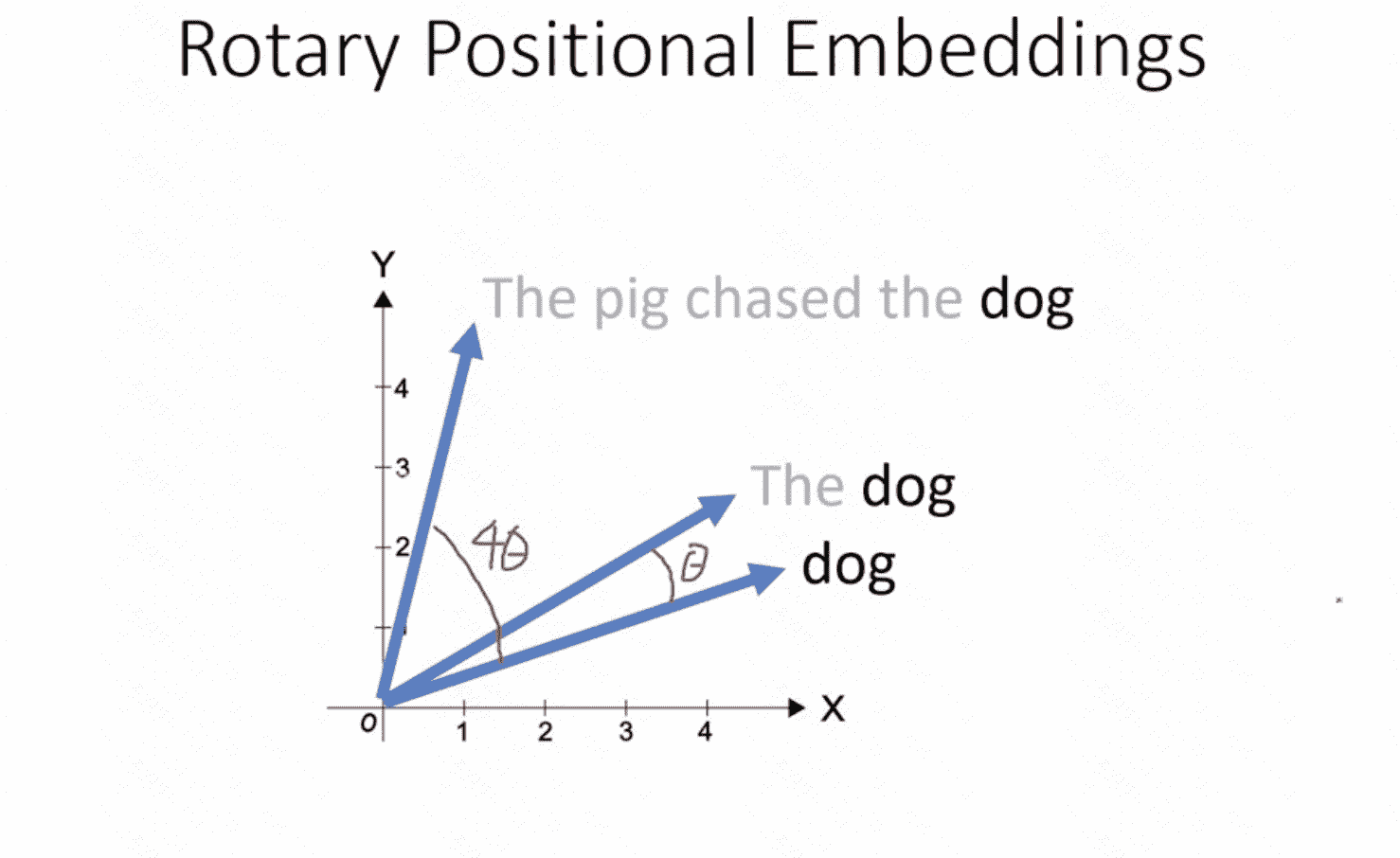

旋转Embedding向量!

- 二维表示

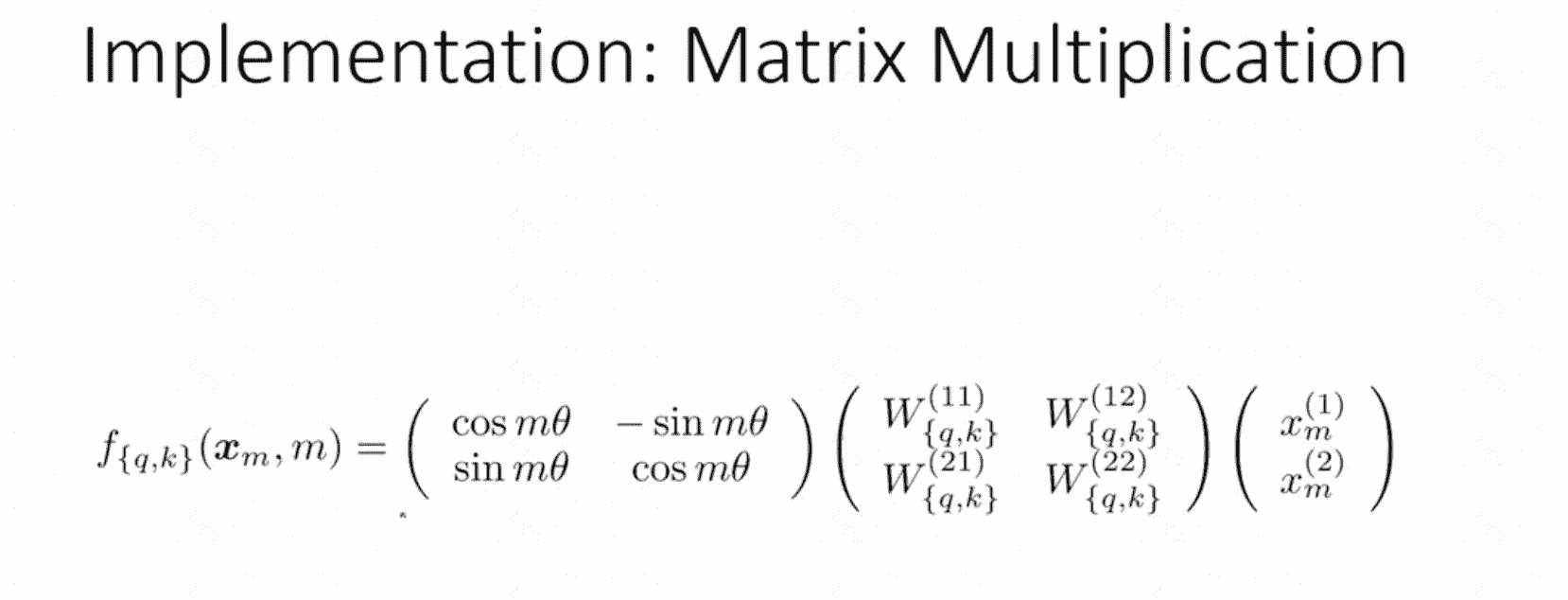

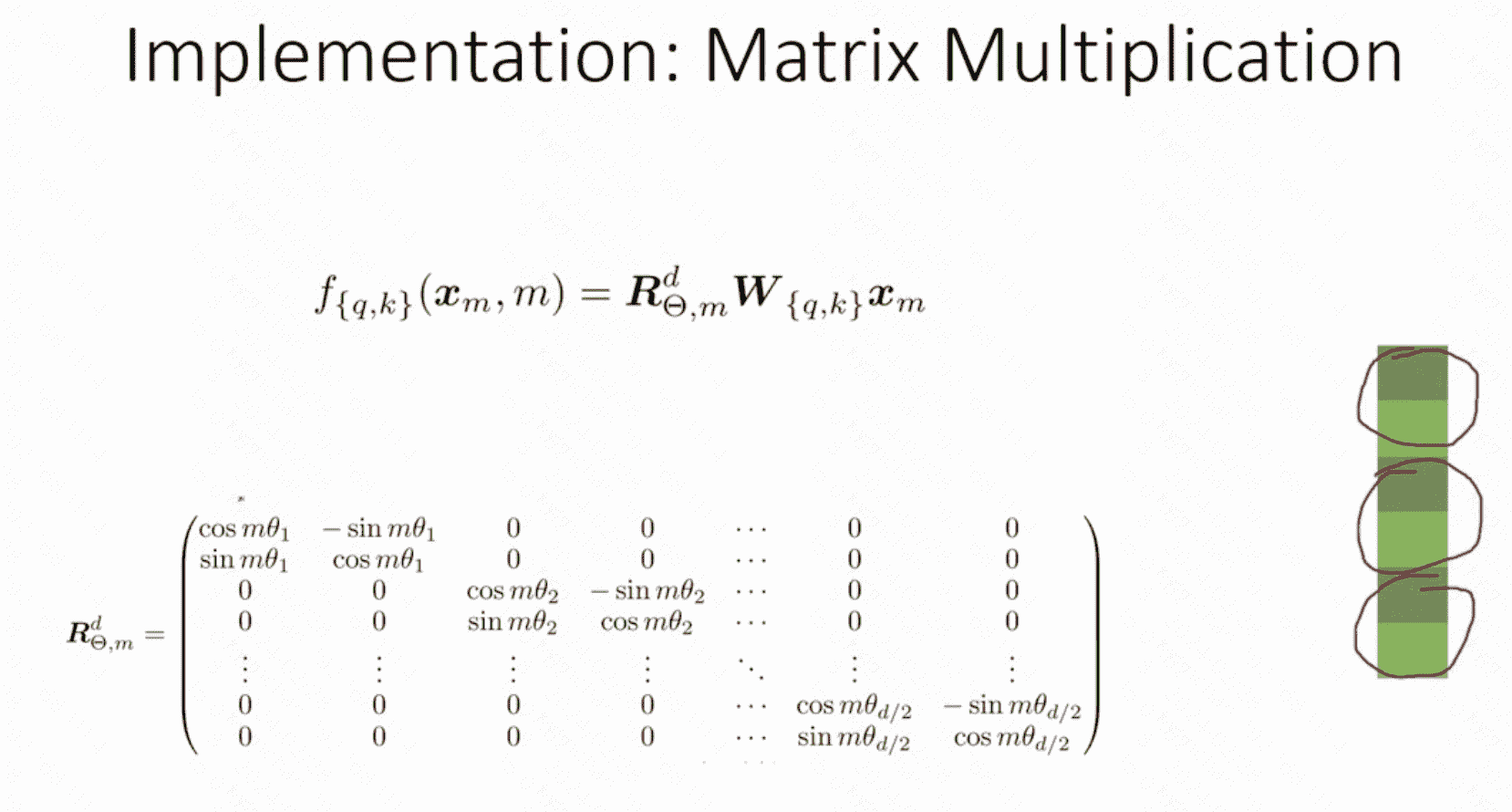

- n维表示

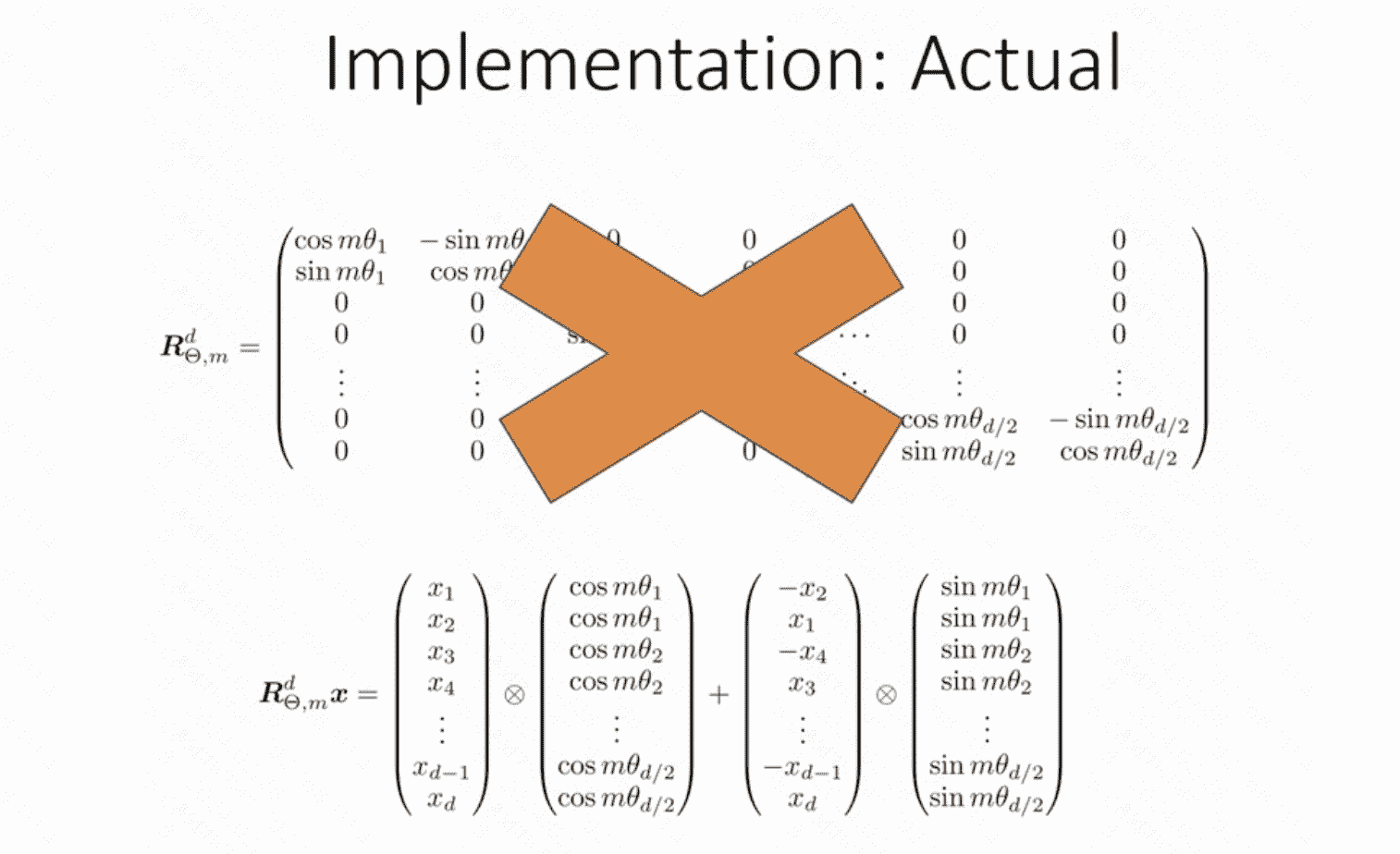

- 实际上更简洁的n维表示

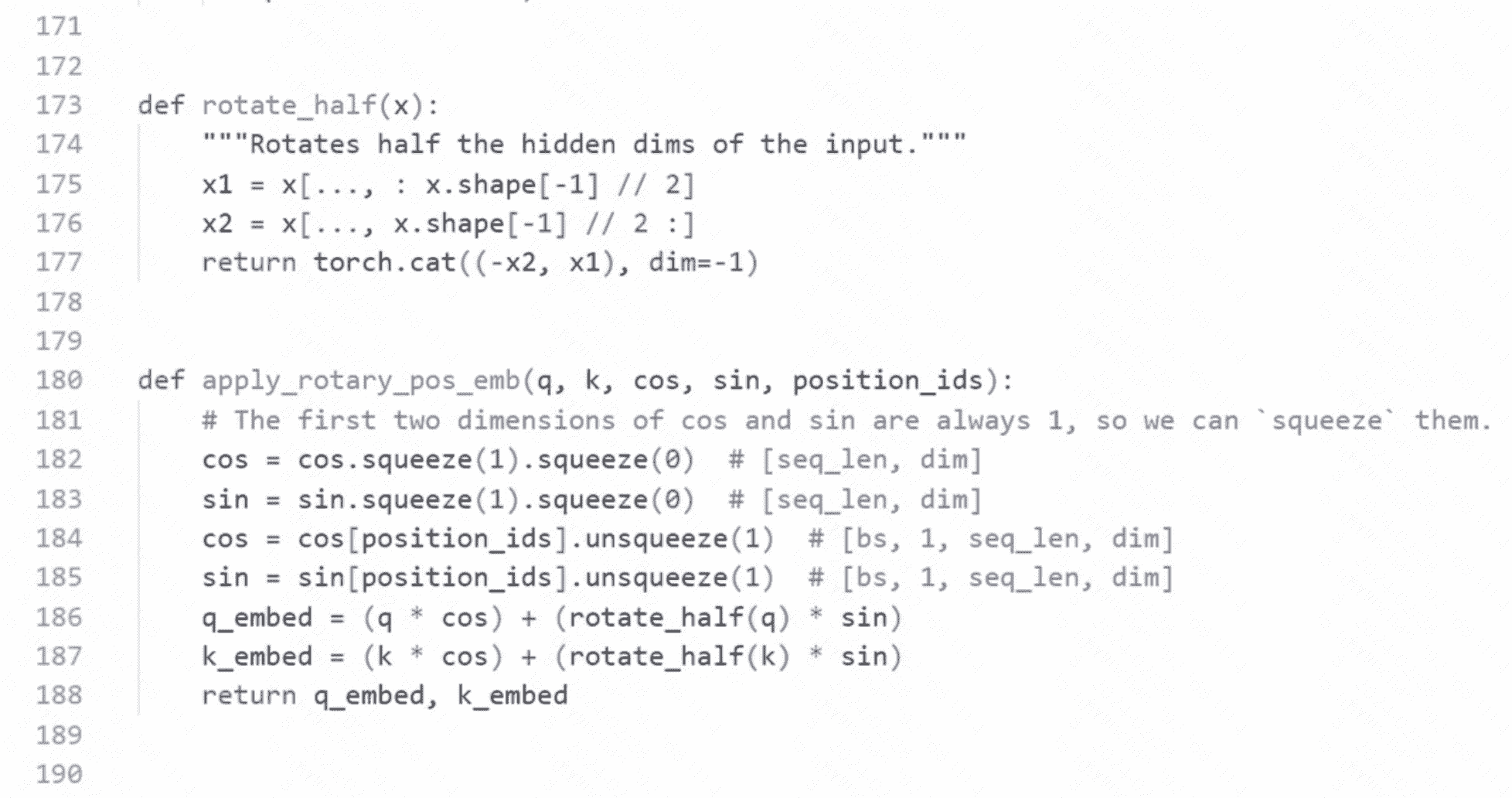

RoPE Implementation

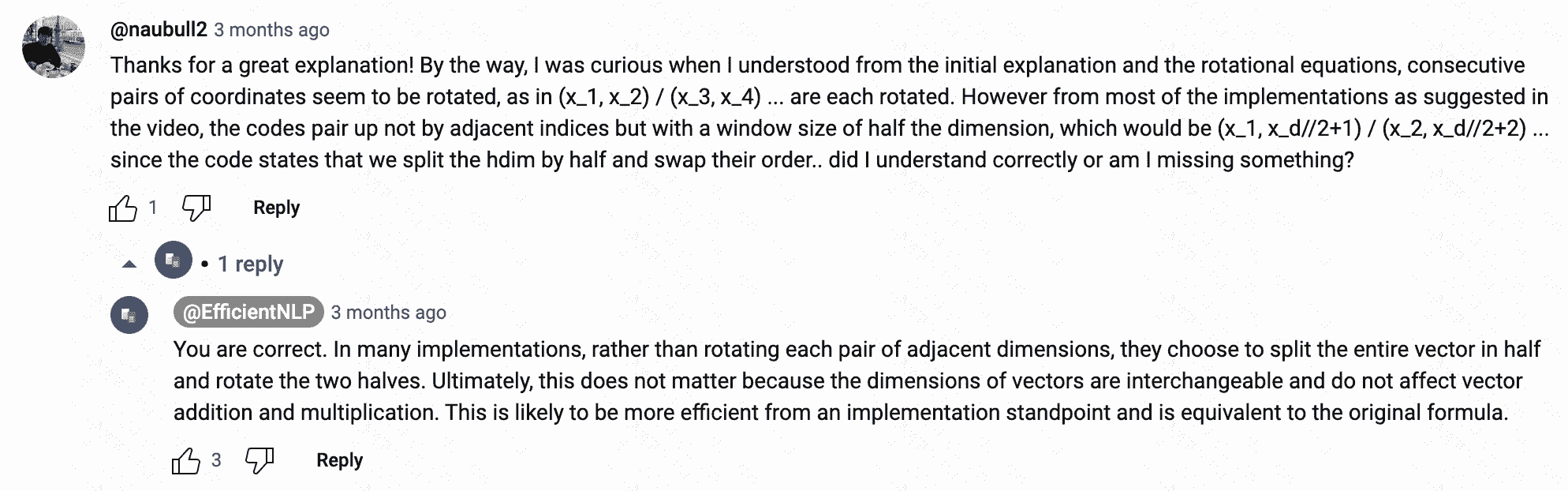

注意看这个代码实现和公式不对应,找到一个解释1:

Reference

-

Rotary Positional Embeddings: Combining Absolute and Relative. https://www.youtube.com/watch?v=o29P0Kpobz0 ↩